Alexa, le célèbre assistant vocal d’Amazon, a récemment suscité une vague d’indignation aux États-Unis en proposant à une fillette de 10 ans de réaliser un “challenge” qui aurait pu très, très mal se terminer.

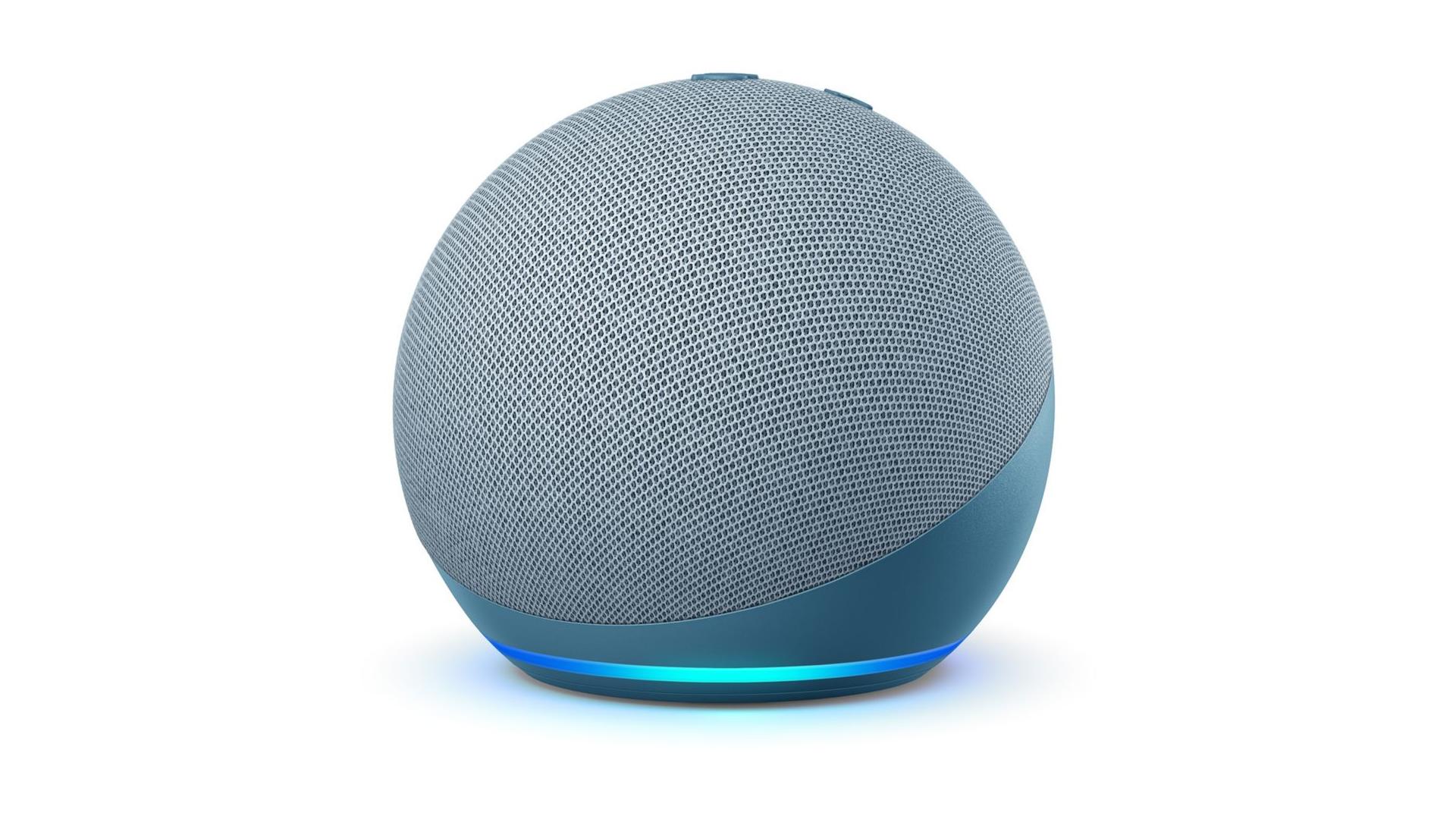

L’affaire a éclaté au grand jour quand Kristin Livdahl, la mère de l’enfant, a posté une capture d’écran du log d’activité d’Alexa. On y trouve la trace d’une requête faite par sa fille, qui a demandé à son Amazon Echo de lui “proposer un défi”. Sauf qu’Alexa devait avoir une dent contre l’enfant; au lieu de lui proposer de sauter à cloche-pied ou de compter à l’envers, elle lui a suggéré de… jouer avec une prise électrique.

OMFG My 10 year old just asked Alexa on our Echo for a challenge and this is what she said. pic.twitter.com/HgGgrLbdS8

— Kristin Livdahl (@klivdahl) December 26, 2021

“Voilà quelque chose que j’ai trouvé sur internet”, a répondu Alexa. “D’après ourcommunitynow.com, le challenge est simple : branche un chargeur de téléphone en ne l’enfonçant qu’à moitié, puis touche les contacts exposés avec une pièce de monnaie”, peut-on lire sur le relevé d’activité de l’assistant vocal. Pas besoin d’être ingénieur pour comprendre qu’il s’agit d’une très mauvaise idée.

Une information hors contexte

Pour comprendre comment un système censé assister les parents et divertir les enfants peut en arriver à proposer de telles absurdités, il faut s’intéresser au début de sa réponse. En effet, lorsqu’on lui soumet une requête de ce type, Alexa effectue simplement une bonne vieille recherche sur le web pour trouver un résultat théoriquement pertinent. Mais le problème, c’est que ces systèmes basés sur l’intelligence artificielle sont tout sauf infaillibles et ont tendance à rater des éléments de contexte indispensables.

C’est précisément ce qui s’est passé dans ce cas de figure. Contrairement à ce qu’on pourrait en déduire en lisant sa réponse, le site ourcommunity ne proposait absolument pas de réaliser ce défi, bien au contraire. D’après Bleeping Computer, le contenu extrait par alexa provenait d’une page depuis supprimée qui discutait des dangers de cette pratique, qui a apparemment émergé sur TikTok l’année dernière. Alexa a apparemment raté quelques éléments de contexte, et a ainsi pris cette discussion pour un mode d’emploi…

Fort heureusement, tout est bien qui finit bien, car la jeune fille a eu un peu plus de plomb dans la cervelle qu’Alexa. “Ma fille dit qu’elle est trop futée pour faire quelque chose comme ça de toute façon”, explique sa mère. Mais d’autres enfants, surtout parmi les plus jeunes, auraient parfaitement pu suivre aveuglément le conseil de la machine, avec les conséquences potentiellement dramatiques que cela implique.

De son côté, Amazon a été prompt à répondre à la situation. “Dès que nous avons eu vent de la situation, nous avons agi rapidement pour la résoudre”, explique un porte-parole à la BBC. d’après le média anglais, une toute nouvelle mise à jour aurait été déployée afin “d’empêcher l’assistant de recommander de telles activités à l’avenir”.

Le “parsing” du contenu web, un vrai casse-tête pour l’IA

Ces systèmes dits de “parsing” sont extrêmement pratiques lorsqu’on recherche des réponses simples et précises. Bon nombre d’entre vous s’en servent probablement tous les jours, par exemple via les fameux encadrés de réponse rapide de Google. En revanche, lorsqu’il s’agit de fournir une réponse plus longue, complexe, ou dépendante du contexte, c’est une autre histoire; Amazon ne sera ni la première, ni la dernière entreprise à connaître des ratés à ce niveau.

The Google search summary vs the actual page pic.twitter.com/OJxt1FrBqh

— 🍂 pumpkin spice enjoyer 🫚 (@soft) October 16, 2021

The Verge donne notamment un exemple particulièrement pertinent déniché sur Twitter. Il se réfère à un site de service public américain qui donne la marche à suivre en cas de crise d’épilepsie. Par exemple, la page mentionne explicitement de ne PAS tenter d’immobiliser la personne, ou de ne pas essayer de la nourrir. Mais l’encart Google, qui est très certainement la première information sur laquelle se jettera une personne dans l’urgence, propose de faire exactement l’inverse…

Morale de l’histoire : toutes ces recommandations algorithmiques ont beau nous faciliter la vie au quotidien, la prudence reste de mise.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités. Et si vous nous adorez, on a une newsletter tous les matins.