Depuis notre plus tendre enfance, nous avons tous appris les rudiments des nombres en passant par plusieurs étapes de base. Par exemple, même les plus grands cerveaux de l’histoire des mathématiques ont commencé en comptant sur leurs doigts avant de passer aux additions et aux multiplications.

Lorsqu’on s’aventure plus loin, on commence à rencontrer des notions un peu plus abstraites, comme les équations imaginées par le mathématicien perse Muhammad ibn Mūsā al-Khwārizmi il y a des siècles. Tous ces outils ont permis aux humains d’étudier des concepts mathématiques de plus en plus poussés.

Ces développements ont eux-mêmes conduit à l’apparition de nouveaux outils révolutionnaires, à commencer par l’informatique. Les ordinateurs sont capables d’ingurgiter des problèmes mathématiques très complexes, puis de proposer une réponse fiable en moins de temps qu’il n’en faut à un humain pour lire l’énoncé.

Forcément, cette technologie a complètement révolutionné tous les travaux qui impliquent des calculs complexes. Par exemple, dans les années 50, la NASA s’appuyait sur une véritable armée d’« ordinateurs humains » qui calculaient, entre autres, toutes les trajectoires des fusées à l’aide d’une calculatrice rudimentaire. Cette profession a été rendue complètement obsolète par la montée en puissance de l’informatique.

Instinctivement, on pourrait donc se dire que le problème de la complexité des équations a plus ou moins disparu. Après tout, en cas de pépin, il suffit d’augmenter la puissance de la machine, n’est-ce pas ? C’est en fait plus compliqué que cela. Car plus la science avance, plus les besoins en termes de puissance de calcul augmentent de façon exponentielle.

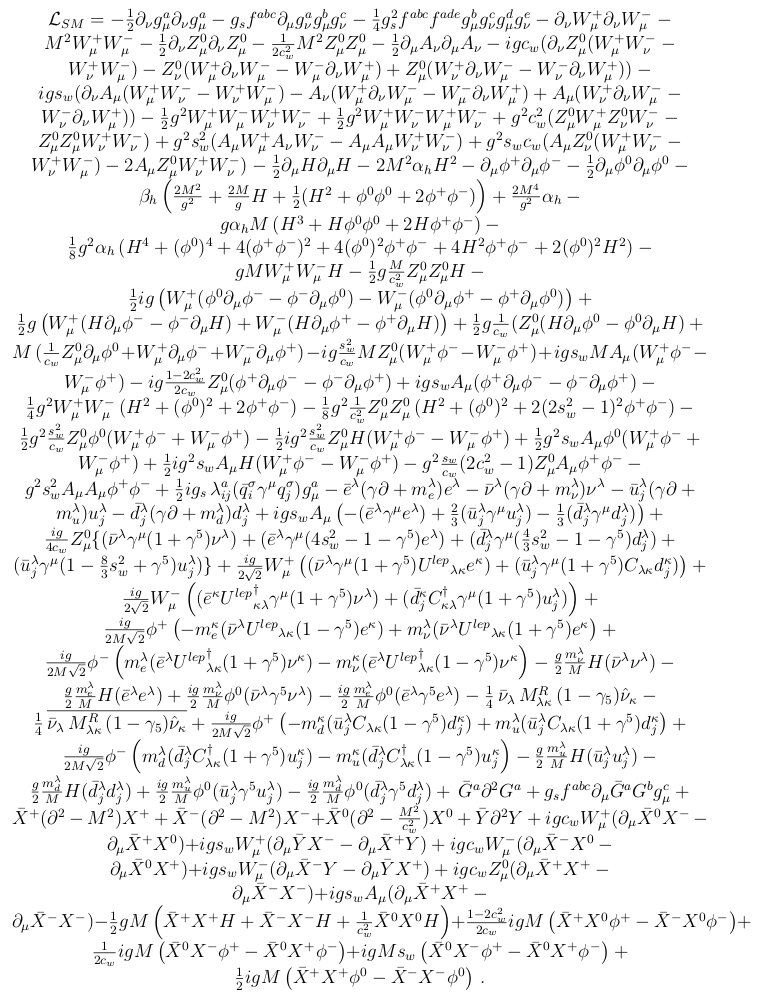

La physique des particules, une torture pour les machines

C’est en partie la faute des physiciens, et en particulier ceux qui travaillent à la plus petite des échelles. En effet, la physique des particules fait intervenir certaines des équations les plus longues qui soient. Et surtout, leur complexité augmente à une vitesse affolante dès qu’on intègre de nouveaux paramètres. Pour l’anecdote, dans ce contexte, on ne peut même plus parler de hausse exponentielle ; les spécialistes parlent plutôt de hausse factorielle.

Autant dire qu’il est tout simplement illusoire d’espérer dompter ces monstres mathématiques avec un crayon et du papier… et pendant longtemps, même les processeurs les plus puissants ont eu toutes les peines du monde à y parvenir.

En effet, les premiers ordinateurs disposaient de quantités de mémoire vive ridicules par rapport aux machines modernes. Et cela posait un problème de taille — littéralement. Car pour traiter une équation, un ordinateur doit d’abord la stocker dans sa RAM ; or, les équations de physique des particules étaient tout simplement trop longues pour être conservées en entier dans la mémoire vive !

Résultat, il fallait les stocker en partie sur un disque dur standard (HDD). Les données devaient donc multiplier les allers-retours entre le disque dur et la RAM. Cela a pour effet de ralentir encore davantage la résolution de ces équations déjà effroyablement difficiles à traiter.

FORM, une révolution pour la recherche

Pour éviter de se retrouver dans un cul-de-sac technologique en attendant d’avoir accès à davantage de RAM, il a donc fallu opter pour un autre angle d’attaque : l’optimisation du versant logiciel. C’est ainsi que dans les années 1980, un physicien néerlandais du nom de Jos Vermassen a accouché d’un programme qui allait changer radicalement le quotidien des chercheurs.

Le programme en question, baptisé FORM, permet de contourner ce problème de mémoire. Le physicien Matt von Hippel explique qu’il permet de découper ces équations en différents termes, puis d’assigner chacun d’entre eux à une zone prédéterminée du disque dur.

En d’autres termes, cela permet au processeur de traiter le HDD un peu comme de la RAM. Grâce à cette réorganisation opérée par FORM, ces équations colossales peuvent être traitées beaucoup plus rapidement.

Cette technique a tellement bien fonctionné que FORM s’est immédiatement imposé comme un outil incontournable en physique des particules. Et son importance n’a pas diminué depuis, malgré l’augmentation radicale des quantités de mémoire vive. Aujourd’hui encore, plusieurs articles scientifiques basés sur FORM sont encore publiés chaque semaine. « La plupart des résultats de haute précision que notre groupe a obtenus sur les 20 dernières années étaient largement basés sur du code FORM », explique Thomas Gehrmann, un physicien suisse interviewé par Quanta Magazine.

Et tout indique que cet algorithme continuera de jouer un rôle déterminant à l’avenir. « Ce concept restera pertinent, peu importe la croissance de la mémoire, parce qu’il y aura toujours un problème de physique qui sera limité par la quantité de mémoire disponible », explique Ben Ruijl, un ancien étudiant de Vermaseren aussi interviewé par Quanta.

… qui menace de tomber en ruine

Ou du moins, les chercheurs espèrent qu’il en sera capable. Car cet état de fait pourrait être remis en question. En effet, même s’il ne s’agit pas d’outils physiques, les logiciels ne sont pas éternels pour autant. Au fil des mutations de l’informatique, il faut aussi réaliser des maintenances et mises à jour régulières pour qu’ils restent compatibles avec le reste de l’écosystème. Et c’est là que les physiciens se retrouvent confrontés à un très, très gros problème.

Il s’agit en effet d’un logiciel formidablement complexe et surtout ultraspécialisé. Comprendre les détails de son fonctionnement nécessite des connaissances extrêmement poussées en informatique fondamentale. Un champ de compétence largement hors de portée pour la plupart des spécialistes de la physique des particules, qui ont déjà fort à faire dans leur propre discipline.

Cela signifie qu’il n’y a pas beaucoup de personnes qui disposent de compétences suffisantes dans ces deux domaines pour assurer l’entretien de FORM. En fait, il n’y a même qu’un seul humain capable de le faire à l’heure actuelle… et il s’agit de Vermaseren, le père du logiciel en personne.

Or, à 73 ans passés, l’intéressé commence à se diriger vers une retraite bien méritée. Mais il tarde encore à se mettre complètement à l’écart, et pour cause : il n’y a pas encore le moindre successeur à l’horizon !

Si personne ne parvient à reprendre le flambeau, le logiciel va progressivement devenir de moins en moins utilisable, puis complètement obsolète. Et connaissant son importance, c’est toute la recherche en physique des particules pourrait en faire les frais pendant de longues années.

Un des nombreux effet pervers de la course à la publication

La grande question, c’est de savoir comment nous avons pu en arriver là. Comment se fait-il qu’une discipline scientifique de pointe, en plein boom en ce moment, dépende à ce point d’une unique solution logicielle maîtrisée par une seule personne dans le monde ? La réponse émerge d’un des grands problèmes de la recherche moderne, à savoir la pression de la publication.

Pour accéder aux revues scientifiques prestigieuses, trouver des fonds et viser des récompenses comme le Nobel, il faut d’abord gagner en notoriété. Et forcément, cela implique de se montrer. Pour un jeune chercheur, cela passe obligatoirement par le fait de publier une quantité considérable de papiers de recherche qui seront idéalement cités par d’autres chercheurs.

Certaines thématiques génèrent donc une visibilité importante. A l’inverse, d’autres travaux ont tendance à passer presque inaperçus. Annoncez la découverte d’une nouvelle particule après une mesure révolutionnaire, et pouf ! Vous obtenez un scoop scientifique garanti. Par contre, pour tous les chercheurs qui ont participé au développement des outils nécessaires, l’exposition sera beaucoup, beaucoup moins importante.

Pour un jeune chercheur, la conclusion est donc claire : aujourd’hui, la voie royale, c’est de proposer des résultats expérimentaux marquants. À l’inverse, se spécialiser dans la maintenance des outils, c’est souvent le meilleur moyen de finir sa carrière aux oubliettes académiques, ce qui équivaut à un suicide professionnel pour un débutant très ambitieux. Sans surprise, des tas de jeunes pousses prometteuses préfèrent donc se détourner de ce plan de carrière.

Un problème systémique qui mérite plus d’attention

On comprend aisément pourquoi Vermaseren a tant de mal à trouver un successeur pour entretenir FORM. Certes, Ben Ruijl travaille « sporadiquement » sur le programme avec quelques autres anciens padawans du créateur. Mais pour faire avancer leurs carrières respectives, ils doivent aussi publier leurs propres travaux. Impossible de se consacrer exclusivement à FORM. C’est donc le pseudo-retraité qui assume encore le plus gros du travail.

À court de solutions et probablement épuisé, il a donc pris le taureau par les cornes. En avril prochain, il organisera un vaste colloque avec les utilisateurs de FORM pour discuter de son avenir. Avec un peu de chance, cela permettra peut-être de faire émerger un successeur. Ou au moins de trouver des pistes pour sauver ce que Matt von Hippel décrit comme « l’un des outils les plus puissants de la physique ».

Mais même si un petit nouveau reprend les rênes dès demain, ça permettra seulement de traiter les symptômes de ce qui est en fait une maladie systémique bien plus profonde. Le vrai problème, c’est le système actuel qui pousse à la publication tous azimuts, aux dépens de travaux de fond moins « publiables » mais tout aussi importants en pratique.

Le cas de FORM est un exemple particulièrement flagrant. Mais il existe aussi des tas d’autres logiciels et outils de ce genre qui jouent un rôle central dans leurs domaines respectifs. Et la communauté scientifique a parfois tendance à les tenir pour acquis – à tort. Si cette dynamique perdure, à terme, d’autres disciplines pourraient donc se retrouver dans des situations comparables à celle que la physique des particules traverse en ce moment. Il sera donc intéressant de voir si les institutions qui pilotent la recherche scientifique à l’échelle globale sauront tenir compte de ces signaux d’alerte préoccupants.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités. Et si vous nous adorez, on a une newsletter tous les matins.

C’est amusant car travaillant dans l’informatique je constate le même problème, nos patrons aiment montrer à leurs patrons qu’ils ont fait réaliser un nouvel outil ou faute de mieux qu’un logiciel existant a une nouvelle fonctionnalitée.

Par contre financer de la maintenance jamais de la vie, et tant pis si les nouveaux développements doivent venir se greffer à un environnement obsolète.

Article très intéressant, et qui montre de façon plus aiguë le même problème que nous avons sur le logiciel sur lequel je travaille et dont je suis porte-parole: Geant4. C’est un logiciel de simulation des interactions de particules dans la matière. Il est utilisé par les expériences LHC pour simuler la réponse des détecteurs à de la physique “standard” et à de la “nouvelle” physique afin de voir à quoi s’attendre comme différence de réponse. Mais il est aussi utilisé pour beaucoup d’autres choses, comme la simulation de radio- ou particule-thérapie en médecine. Nous avons donc une énorme communauté d’utilisateurs (LHC, médical, spacial, etc.)

Ayant débuté en 1994, nous devons renouveler les équipes de développeurs (physiciens, ingénieurs, sur le sujet pointu de la modélisation Monte Carlo), mais la politique de publication mais aussi celle des contrats courts, nous rendent cette tâche plus qu’ardue : nous devons transmettre à une jeune génération pour du long terme, mais cette jeune génération est sous contrat court…

Le risque de rupture de compétence est très élevé et deviendra réalité d’ici quelques années si les choses n’évoluent pas. Au-delà de Geant4, comme pour FORM, c’est toute la communauté utilisateur qui se verra privée d’un outil dont elle dépend de façon critique pour ses travaux…

Bonsoir

Je lis les différents commentaires sur ce sujet. Je suis un simple citoyen qui reste bouche devant votre savoir. Mon bagage technique est certes bien pauvre par rapport au votre mais je suis toujours stupéfait de cette somme de connaissances que peuvent emmagasiner certains humains. Merci à vous d’utiliser un vocabulaire nous permettant de comprendre dans les grandes lignes vos problèmes et vos connaissances. La vulgarisation scientifique est à mon sens un partage nécessaire pour permettre aux communs des mortels d’apprendre simplement.

Analyse très pertinente, il faudrait inverser les rôles en ce sens, donner plus de valeurs aux travaux moins publiables et mettre en concurrence la publicité dans la compétence pour l’autorisation de sa publication.

arretez de croire ce qu’on raconte dans le journal du geek, vous faites peine a voir,

dans une collabaration avec plusieurs dizaines de milliers de personnes, telle qu’au CERN, rien ne repose jamais sur une personne, c’est juste un article mytho pour faire du buzz,

prenez contact avec le CERN, posez leur des questions, et celle-la aussi.

Arretez de croire n’importe quoi, et allez toujours vérifier, la c’est très facile, cern.ch, et prenez contact, renseignez vous.

a bon entendeur

Obligatory XKCD Reference: https://xkcd.com/2347/ 😁

Ah, oops, déjà fait dans l’article original de Quanta Magazine 😅…

Le pere noel, rien qu’avec se pseudo, difficile de lui prêter une attention mais bon je vois l’intérêt d’écrire ce genre de commentaire.

Donc argumente un peux plus, juste dire allez poser la question au CERN ou alors allez vérifier blabla..

Bref il n’est pas question de reposer sur une personne, il est question ici dans cette article de relève à temps plein, il y a d’autres personnes, si tu avais un peut plus lu l’article tu aurais vu cette phrase ” Certes, Ben Ruijl travaille « sporadiquement » sur le programme avec quelques autres anciens padawans du créateur”.

Il n’a jamais était question de “il n’y a plus personne qui peut assurer le fonctionne du logiciel” on parle de maintenance, visibilité et de la valorisation du travail que doit fournir ce poste et toute la difficulté à long terme pour les futur opérateurs de maintenance. Il est dit dans l’article que les gens ne sont pas forcément intéressé par ce travail car aucun avenir donc tu imagine bien que le CERN sont bas complètement les roubignoles tant qu’il y aura des gens qui sont la 50% du temps (tant que ca fait le taff).

Bref en faite ta tout écrit dans l’article mais tu te contente de lire son Titre…

Mr le Pere Noel vous êtes hors du temps/sujet

A bon entendeur

Intéressant en effet. La question de la place de la “technique” (des logiciels) au sein du monde académique apparaît en toile de fond. Comme le souligne @Marc-Verderi, d’autres équipes (telles que celle autour de Geant4) sont confrontée à des problématiques très similaires. Étant passé par là en tant que “junior” (Geant4, Geant4-DNA pour le clin d’œil), je ne peux que confirmer ce qui est dit dans l’article et les commentaires.

Voyez vous, un junior se retrouve dans une position quasi-intenable car, si tout se déroule bien, le junior acquiert des compétences et notions très pointues en développement logiciel (et en science). Le volet technique de ces compétences est actuellement très recherché un peu partout dans le monde (là aussi, je suis bien placé étant maintenant à la tête d’une boite de développement logiciel). Le junior se voit donc placé face à un choix : continuer dans la recherche dans des conditions inconfortables (précarité des contrats, financements aléatoires des projets, faible reconnaissance car “c’est de la technique pas de la science”, petit salaire) ou partir vers le “privé” où les conditions d’exercice sont bien plus confortables et les défis également intéressants (par ex. la recherche sur l’IA effectuée par les GAFA, la création de RUST par les équipes Mozilla, les projets open-source tels que CesiumJS etc.) malgré la différence de contexte et la perte des avantages inhérents au monde académique (grande liberté, passion, idéal de la recherche scientifique etc.). Ajoutez à cela que les conditions du cadre académique n’encouragent pas une ambiance “saine” et ce n’est qu’une question de temps avant que la majorité des juniors ne basculent vers ce que j’appelle ici “le privé” par simplicité.

On pourrait aussi poser la question encore plus générale de la maintenance des logiciels quelque soit le contexte. Dans le “privé”, cette question existe aussi mais je trouve que son “intensité” est moindre car des budgets sont généralement débloqués “à temps” dès que des blocages apparaissent. Et surtout, les temps de formation des juniors sont moins longs que sur des sujets tels que la physique des particules.

En vrac, quelques pistes “naïves” :

– Un mécanisme de “semi retraite” où un senior réduirait son activité de 50% afin de laisser la place à un junior qu’il formerait à sa succession. On imagine bien les difficultés mais peut-être que si c’était soutenu par les institutions (surtout financé) alors cela pourrait faire sens.

– Essayer “de récupérer” des seniors du privé via des échanges avec les acteurs du privé (formation en science en échange de temps de travail, que sais-je…).

– Dans la même idée, peut-être que des formes de partenariat serait envisageable. C’est difficile car les temporalités sont extrêmement différentes : signer un contrat ne peut pas attendre 6 mois dans le privé, les équipes ne seront plus disponibles.

– Donner des perspectives plus claires aux jeunes. Si un poste doit être créé alors il est dommage de dire : “ce sera 2 ans après la fin de ton contrat” car, évidemment, le jeune sera parti… Et la formation à reprendre depuis 0.

– Admettre officiellement que des postes croisant les compétences scientifique et technique/logicielle sont nécessaires : produire et mettre à disposition d’une communauté scientifique un nouvel outil logiciel doit avoir une valeur. Sans cela, tout le monde a intérêt à garder pour soi ses propre outils et à ne publier que les résultats (parfois difficilement vérifiables par ailleurs…). Pour ceux non versés dans ces domaines, le point clef est que la mise à disposition du public d’un outil prend beaucoup de temps. Temps qui pourrait être aussi bien être utilisé pour faire 100 publications avec une version “perso” de l’outil. Des outils tels que GEANT4, FORM, GATE, ROOT-CERN sont bâtis sur l’idée que le partage a autant de valeurs que ces 100 publications (ou plutôt 1000 dans les cas que je cite).

L’origine de FORM est SCHOONSHIP de Veltman https://en.m.wikipedia.org/wiki/Schoonschip. En fait c’est presque le même programme (le premier écrit en C et le second a été écrit en fortran puis en assembleur). La version en C rendait plus facile la portabilité aux différentes machines. Voici quelques mots clés pour en savoir plus : Macsyma, SMP, Mathematica.

Article très intéressant j’aime j’aime ! Continuez avec des articles aussi bien faits.

il suffirait pourtant de faire payer une licence à tous les utilisateurs de FORM

–> Vermaseren aurait ensuite les moyens de rémunérer des gens qui font une carrière moyenne avec un salaire à faire baver ceux qui font une carrière brillante…

Ici comme dans d’autre domaine, ce qui n’a pas de prix ne compte malheureusement pas…

Peut être qu’une approche plus “industrielle” apportait un début de solution.

Cela consiste en

– des spécifications fonctionnelles

– de performances

– la pérennité du langage de codage et des bibliothèques

Dans ce contexte, les spec évoluent grace à la communauté scientifique et qui développe le code devient un soucis secondaire.

Je trouve très étonnant que les organismes qui étudient la physique des particules soient démunis face à un soucis de génie logiciel aussi classique.

Le PB ne serait il pas ailleurs ?

J’ai rarement (voir jamais) vu un sujet d’article aussi intéressant que celui-ci sur le net mais également des commentaires très constructifs sur la problématique que pose le sujet. On constate les faits, certes, des solutions sont évoquées mais y aura-t-il des suites ? Je l’espère vraiment… Mention à Syl pour son exposé ^^ on en redemande ! (moi en tout cas)

Une Personne seule n’est indispensable, tjs c’est le travail d’équipe. Une nouvelle génération naisse, une vieille parte.

Et c’est ça le sens de la vie.

@issh vous m’enlevez les mots de la bouche… même si je n’oserais jamais me mettre au niveau des acteurs de l’article…. dans le prive on se rappelle des services informatiques que quand ça tombe en rade pour leur taper sur la tête… alors que les dirigeants ont limités les invests , maintenus des incompétents à des postes importants… bloquant tout, prenant des décisions absurdes…etc.

@francois vous me semblez faire preuve d’une naïveté sur le caractère “industriel” du développement informatique qui est confondante …

Nb : g eu le Top 12 des concours d’inge en 3/2 (M’ puis MP* aujourd’hui) il y a 47 ans…

Que la super I.A. le prenne en charge et s’en occupe ! Elle va y arriver, puisqu’elle est si forte et promise à nous surpasser.

C’est la domination moderne de l’individualisme, de la compétition court-termiste au détriment de la collaboration, de la planification collective et même démocratique des projets qui amènent à ce genre de faillites.