Ce 15 janvier marque l’ouverture du Forum économique mondial, plus connu sous le nom de Forum de Davos en référence à la ville Suisse où il se tient chaque année. Les participants de cette grand-messe des affaires et du lobbying ont dévoilé leur liste des 10 menaces les plus importantes pour l’humanité, à court et à moyen terme : voici ce que le gratin de l’économie mondiale pense de notre futur commun.

Ce sondage annuel appelé Global Risk Report propose à cette cohorte de grands patrons, de milliardaires, de banquiers et de responsables politiques de classer les différents risques encourus par l’humanité en fonction de leur sévérité. Ces pronostics sont séparés en plusieurs catégories distinctes. La première d’entre elles porte sur le court terme, et plus spécifiquement sur l’année à venir.

Du climat et de l’IA

Sans surprise, la grande majorité des sondés (66 %) estime que ce sont les phénomènes climatiques extrêmes qui seront le plus à même de provoquer une crise globale en 2024. Les votants ont insisté sur le fait qu’en dépit d’une certaine prise de conscience collective, les décideurs politiques traînent encore à joindre la parole aux actes. Selon eux, les nations restent très mal préparées au « déclenchement d’effets sur le long terme potentiellement irréversibles et autoentretenus » qui menacent de défigurer notre planète.

En deuxième position, on retrouve une thématique qui ne cesse de faire les gros titres depuis quelques mois : l’intelligence artificielle. 53 % des sondés considèrent que les risques posés par cette technologie constituent une menace majeure à court terme — plus que la polarisation sociale et politique (46 %) et la crise du coût de la vie (42 %).

Une technologie qui inquiète

Pour expliquer cette méfiance vis-à-vis de cette technologie, les participants du Forum citent surtout les risques de désinformation. « Dans les mains des mauvais acteurs, l’IA a le potentiel d’inonder les systèmes d’information globaux de fausses informations », explique le rapport.

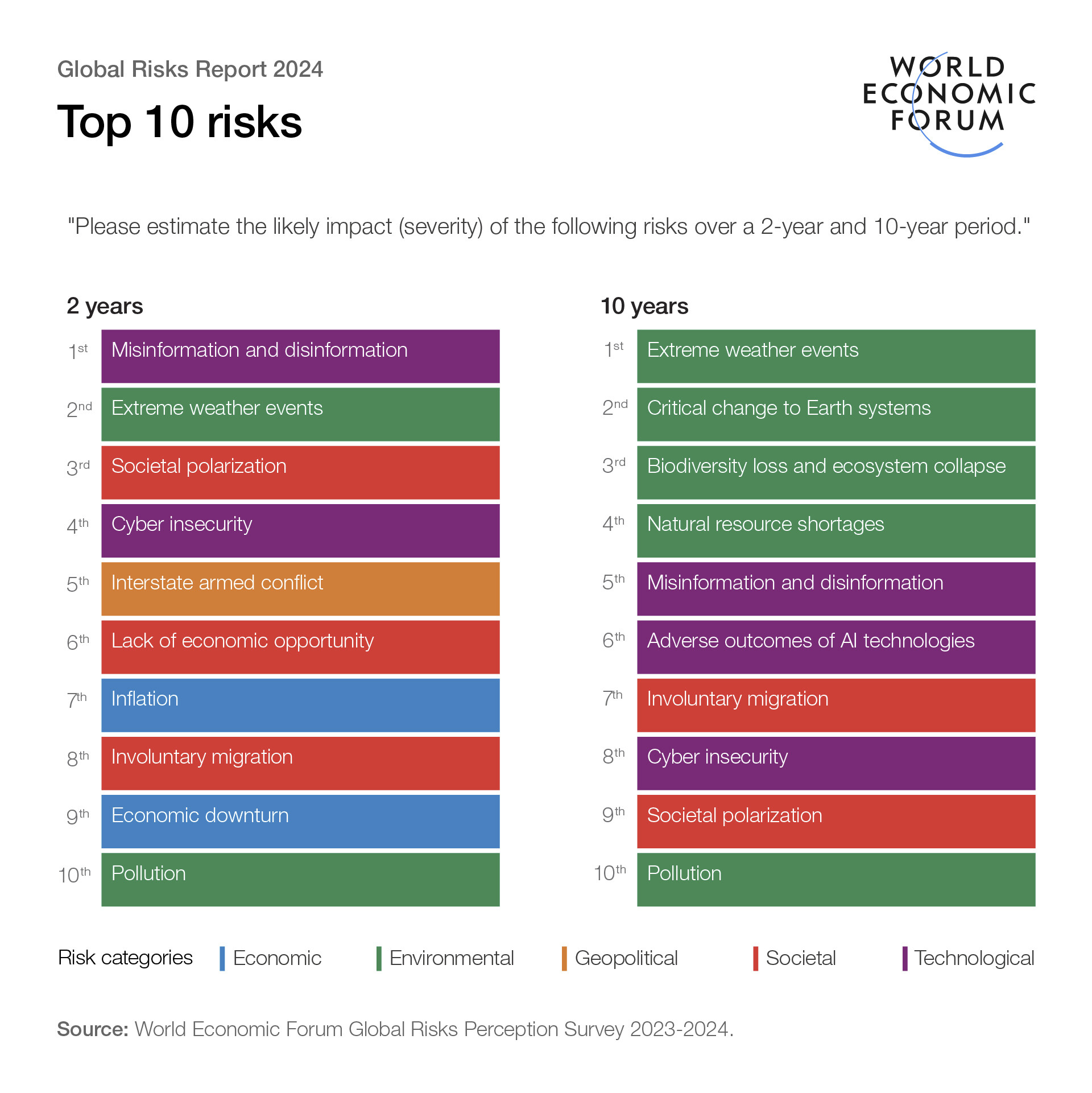

Et apparemment, ils considèrent que ce risque va s’accentuer. Sur les deux prochaines années, la désinformation passe même en première position des risques globaux, devant les événements climatiques extrêmes et la polarisation sociétale. Ce dépassement est lié aux grandes échéances qui attendent l’humanité dans cet intervalle de temps.

Les votants estiment que ces risques sont d’autant plus importants en cette période d’élections. En effet, plus de trois milliards de personnes qui vont prendre le chemin des urnes d’ici 2026. Cela concerne notamment l’ Inde, les États-Unis et le Royaume-Uni. Dans ce contexte, la désinformation alimentée par des outils basés sur l’IA « pourrait déboucher des troubles civils, alimenter une censure gouvernementale, une propagande domestique et un contrôle sur la libre circulation de l’information ».

Les votants estiment toutefois que ce risque finira par s’amenuiser. Dans le classement des risques sur les 10 prochaines années, la désinformation tombe en 5e position. Elle se place derrière quatre risques de nature écologique : les événements climatiques extrêmes, les changements critiques aux systèmes de la Terre, l’effondrement des écosystèmes et de la biodiversité, et les pénuries de ressources naturelles. Un constat pas dénué d’ironie, sachant que chaque année, près de la moitié des participants arrivent à Davos… en jet privé.

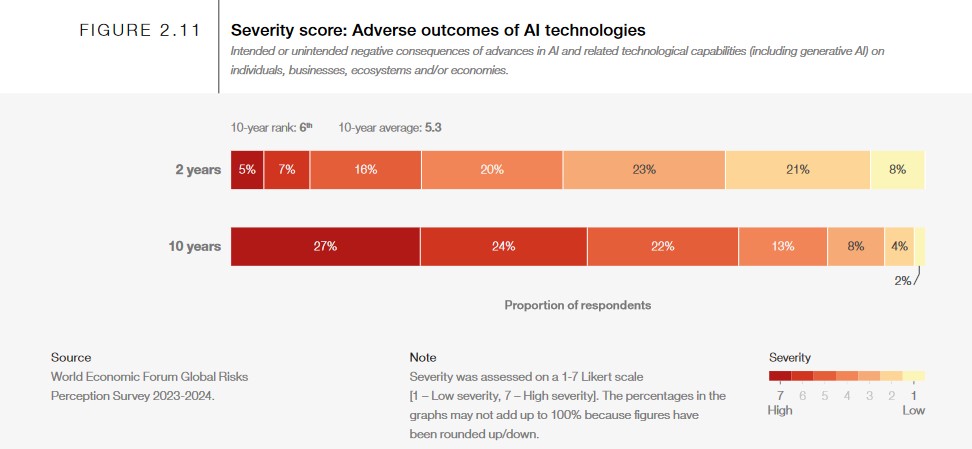

Mais dans ce classement sur le long terme, on constate aussi l’apparition d’une autre thématique en 6e position : les « conséquences néfastes des technologies d’IA ». Par exemple, les participants semblent inquiets à l’idée de voir émerger une intelligence artificielle générale (AGI) en tout point supérieure à celle des humains. Ils citent également le remplacement de certaines branches professionnelles, l’usage de cette technologie à des fins militaires ou de cybercriminalité, ou le rôle qu’elle pourrait jouer dans la prise de décision par les gouvernements et les institutions.

Innovation contre principe de précaution

« À ce jour, le principe de précaution n’a globalement pas été appliqué dans le développement de l’intelligence artificielle, et les régulateurs se sont rangés du côté de l’innovation », peut-on lire dans le rapport. « L’évolution rapide et la dépendance aux IA avancées commencent à surpasser notre capacité à nous y adapter, que ce soit lorsqu’il s’agit de comprendre la technologie en elle-même (problème de la boîte noire) ou de créer des garde-fous réglementaires. »

Ce discours fait écho aux appels de nombreux spécialistes qui ne cessent de réclamer une régulation plus stricte du machine learning. On se souvient notamment de la fameuse tribune signée par 1300 personnalités influentes, dont Elon Musk, qui réclamaient une approche plus précautionneuse.

La bonne nouvelle, c’est que même si sa pertinence est souvent remise en question, le forum de Davos reste un événement auquel la sphère politique et les grandes entreprises continuent de prêter une attention toute particulière.

Il sera donc intéressant de voir ce que les décideurs politiques et les chefs de file de cette niche technologique vont retenir de ce rapport. On pense notamment à Emmanuel Macron, partisan revendiqué d’une approche très libérale sur la régulation de l’IA, et aux cadors de l’industrie comme OpenAI qui ont un intérêt financier à s’affranchir du principe de précaution (voir notre article).

Le texte du rapport est disponible ici.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités. Et si vous nous adorez, on a une newsletter tous les matins.

La’mrnace numéro 1 pour l’humanité étant le forum de Davos