OpenAI, l’un des leaders mondiaux sur le segment de l’intelligence artificielle, propose souvent des travaux révolutionnaires dans ce domaine. Certains de ses projets les plus impressionnants sont basés sur les GPT-n; il s’agit d’une série de modèles linguistiques basés sur le deep learning qui permettent de générer tout ce qui touche de près ou de loin au langage, de la conversation au code informatique.

Le système est si puissant qu’il inquiète même certains observateurs, mais ce n’est pas avec GPT-3 qu’OpenAI s’est illustré récemment. À la place, la firme a dévoilé la nouvelle version de DALL-E, un autre système basé sur l’IA. Lui n’a que faire de générer du texte; à la place, il crée des images à partir d’une description en langage naturel… et le résultat est à tomber par terre.

Du texte à l’image, il n’y a qu’une IA

La première version, dont le nom emprunte à l’illustre peintre Salvador Dali et au robot de Pixar Wall-E, était déjà bluffante. Ce système était déjà capable de représenter visuellement des objets et personnes à partir d’une simple description textuelle. Et cette première version se montrait déjà plutôt agile.

Elle fonctionnait avec une approche conceptuellement assez similaire à GPT-3, ce qui lui offrait une grande flexibilité. Elle fonctionnait avec des descriptions très terre à terre, mais aussi – et c’est assez exceptionnel pour une IA de ce type – avec des propositions beaucoup plus farfelues comme une “illustration d’un radis qui promène son chien”.

DALL-E premier du nom n’avait jamais été proposé en tant que tel au grand public. Mais si le concept vous dit quelque chose, c’est peut-être parce que cela vous évoque le fonctionnement de WomboDream, une application basée sur la première version du système (voir notre article ici).

Elle permet de générer des images stylisées à partir d’un bout de texte fourni par l’utilisateur et de quelques options stylistiques prédéfinies. Le résultat était souvent très intéressant visuellement, à défaut d’être parfaitement cohérents. Il y avait donc déjà de quoi être bluffé. Mais cette deuxième version passe tout simplement dans une autre dimension.

Une deuxième version à tomber par terre

Depuis, il a été largement renforcé par un autre système lui aussi basé sur l’IA. Ce dernier est dérivé d’un système de vision informatique appelé CLIP; il sert à analyser une image pour la décrire à la manière d’un humain. OpenAI a inversé ce procédé pour créer un CLIP, qui permet de guider la composition d’une image à partir de mots.

Grâce à cette procédure, DALL-E 2 peut composer des images à partir d’un processus dit “de diffusion”; il commence par un ensemble anarchique de points, puis remplit l’image au fur et à mesure en affinant progressivement le niveau de détail.

Plus rapide, moins gourmand, globalement mieux optimisé et surtout encore plus puissant, ce DALL-E 2 propose des images qui feront sans aucun doute tomber certains artistes à la renverse. En effet, il dispose désormais d’un arsenal invraisemblable de sous-systèmes qui lui permettent de gérer un nombre de cas de figure tout simplement ahurissant.

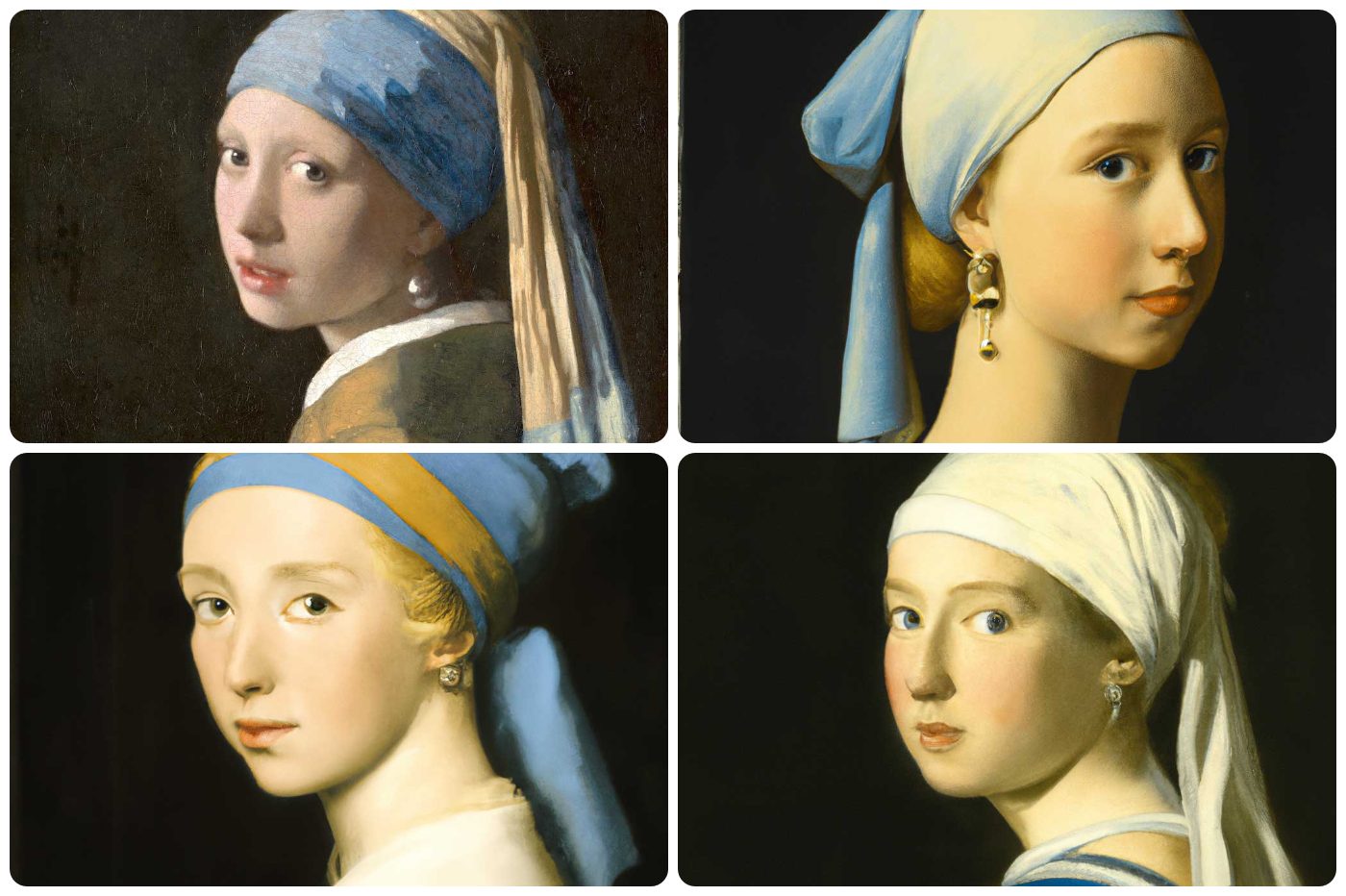

DALL-E 2 est aussi capable d’éditer des images déjà existantes avec un niveau de précision tout simplement invraisemblable. Il est ainsi possible d’ajouter ou de supprimer des éléments tout en prenant en compte la couleur, les reflets, les ombres… Il peut même le faire en respectant le style de l’image originale.

Le système est aussi capable de générer diverses variantes d’un même “output” dans des styles différents, comme les astronautes ci-dessus. Il peut aussi conserver le même style global, comme dans le cas des oursons.

DALL-E 2 est aussi capable de générer des fusions de deux images, avec des éléments caractéristiques tirés des deux sources. Et surtout, il peut faire tout ça à une résolution de 1024 x 1024 pixels, soit 4x celle de son prédécesseur !

Des garde-fous intégrés pour éviter les abus

OpenAI a aussi rajouté des garde-fous censés empêcher les détournements malveillants du système. Par exemple, DALL-E 2 refusera tout simplement de produire la moindre image basée sur un nom réel. L’objectif étant bien évidemment d’empêcher la génération de deepfakes.

Même chose pour toute l’imagerie adulte. C’est aussi le cas pour tous les éléments liés de près ou de loin à des “conspirations”. Pas question non plus de générer du contenu lié “à des événements géopolitiques majeurs actuellement en cours”. Théoriquement, un tel système ne pourrait donc pas être utilisé pour générer du contenu ambigu; nous ne verrons donc pas fleurir de fausses images du conflit russo-ukrainien générées ainsi.

Mais même avec toutes ces barrières, OpenAI reste conscient du potentiel de nuisance de sa superbe technologie. Les futurs utilisateurs devront donc montrer patte blanche; il faudra passer par un long processus de vérification pour obtenir le statut de partenaire. Il faudra donc attendre un certain temps avant que cette 2e version débarque à son tour dans une appli grand public comme WomboDream. Dommage pour ceux qui espéraient déjà s’amuser avec… mais probablement plus raisonnable.

Vous pouvez trouver le papier de recherche ici et l’Instagram d’OpenAI ici.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités. Et si vous nous adorez, on a une newsletter tous les matins.

Bonjour, ça me paraît intéressant mais je ne sais pas où trouver ce DALL.E2 ?

Est ce un logiciel à acheter ?