Si Nvidia s’est récemment installée sur le podium des entreprises les plus riches de la planète, c’est en grande partie grâce à ses GPU H100, des puces surpuissantes que tous les cadors de l’industrie s’arrachent et qui sont devenues le cœur battant de la révolution IA. Mais l’écart est peut-être en train de se creuser encore davantage. L’entreprise de Jensen Huang vient de présenter une toute nouvelle plateforme baptisée Blackwell, et affirme que ce hardware de pointe va faire passer le machine learning dans une nouvelle dimension.

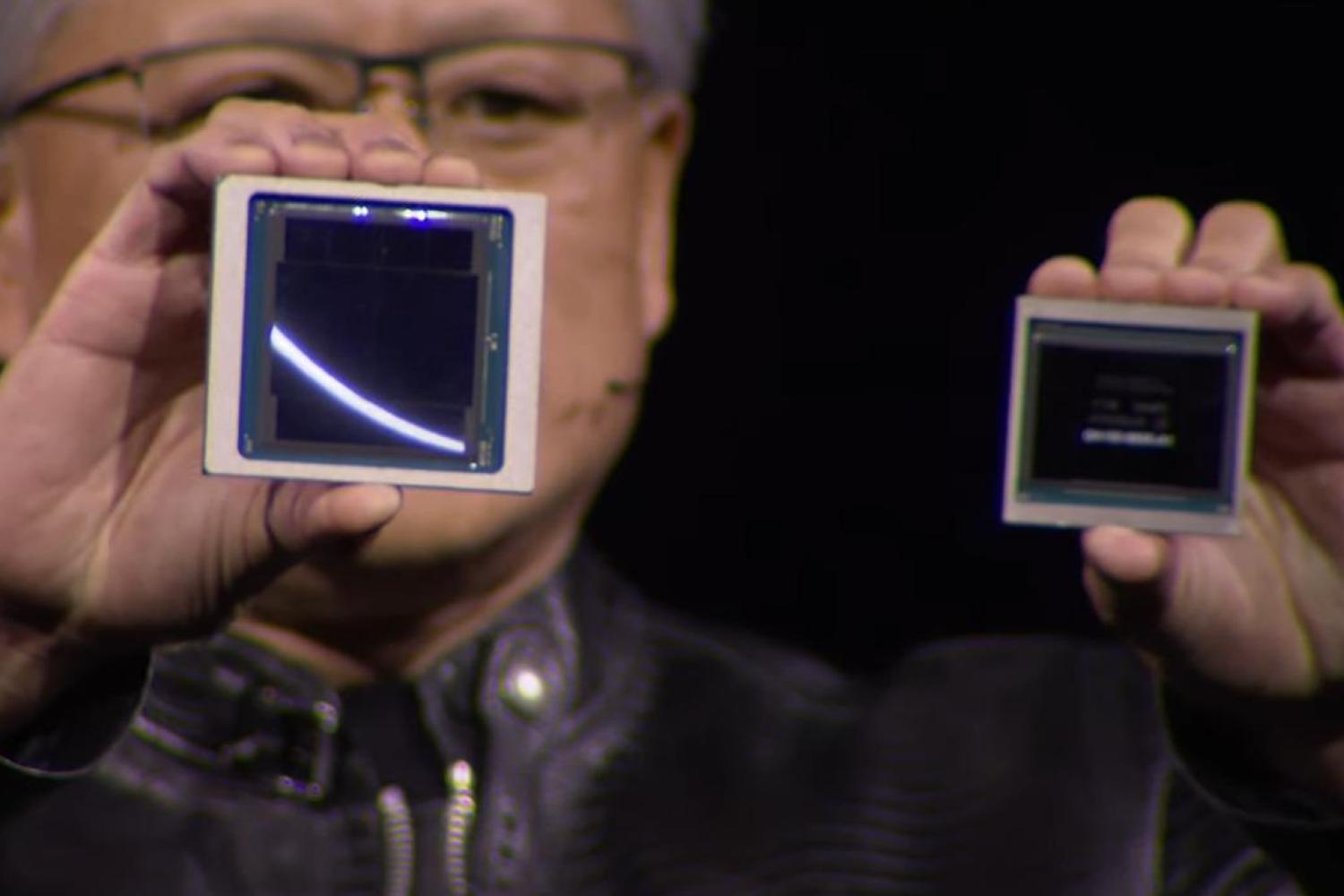

La star, c’est un nouveau GPU sobrement appelé B200. On compte un total de 208 milliards de transistors répartis sur deux chiplets énormes qui communiquent entre eux grâce à une interface à 10 TB/s de bande passante. Elles sont construites grâce au processus N4P de TSMC, une version améliorée du processus 4N utilisé sur les H100.

Le géant taïwanais des semiconducteurs n’a pas révélé beaucoup de détails sur N4P, mais plusieurs experts suggèrent qu’il ne représente pas une grosse montée en gamme en termes de densité des transistors. Pour augmenter la puissance de calcul, il n’y a donc qu’une solution : augmenter la surface. Selon Nvidia, ces chiplets sont les plus grandes puces qu’il est physiquement possible de produire avec les techniques de lithographie actuelle.

Le nouveau roi du hardware IA

Grâce à cette architecture, Nvidia revendique un incroyable 20 petaflops, soit 20 millions de milliards d’opérations par seconde. Pour référence, c’est cinq fois plus que le H100, qui était jusqu’à présent la référence absolue du hardware dédié à l’IA. Mais il convient de prendre les chiffres bruts avec des pincettes, car l’entreprise a utilisé un petit tour de passe-passe discret pour enjoliver la situation.

Pour obtenir ces 20 petaflops, Nvidia s’est appuyée sur un benchmark qui utilise un nouveau format de données appelé FP4, où chaque neurone artificiel a droit à quatre bits de mémoire. Les données peuvent donc être traitées environ deux fois plus vite qu’avec le format FP8 utilisé par les H100. Si l’on se base uniquement sur ce dernier pour réaliser une comparaison directe, le GPU B200 n’est donc “que” 2,5 x plus rapide que son prédécesseur. Mais il s’agit tout de même d’une montée en échelle bluffante.

Nvidia a aussi présenté sa nouvelle « superpuce » GB200, qui combine deux GPU B200 couplés à un exemplaire de son CPU ARM Grace. D’après l’entreprise, elle peut offrir des performances 30 fois supérieures à celles des meilleurs systèmes actuels dans les tâches d’inférence, qui permettent à un modèle IA déjà entraîné de réaliser des prédictions à partir de nouvelles données. L’entraînement en lui-même sera aussi beaucoup plus rapide et économique. Pour entraîner un modèle à 1800 milliards de paramètres, soit à peu près ce que revendique OpenAI avec son GPT-4, il fallait environ 8000 GPU H100 et 15 MWh d’énergie. Il sera désormais possible d’arriver au même résultat avec seulement 2000 GPU B200, et en utilisant seulement 4 MWh. Un véritable tournant générationnel.

Des solutions clé en main pour les cadors de l’industrie

Et comme toujours, Nvidia ne va pas se contenter de vendre ces puces à l’unité. Elle va aussi proposer des solutions clé en main comme le GB200 NVL72, un système qui embarque 36 CPU et 72 GPU. L’ensemble revendique 720 petaflops pour les tâches d’entraînement et 1400 petaflops, soit 1,4 exaflops, pour les tâches d’inférence ! D’après Nvidia, cela permettra d’entraîner des modèles jusqu’à… 27 000 milliards de paramètres.

Et si cela ne suffit toujours pas, qu’à cela ne tienne. Nvidia a aussi dévoilé son nouveau DGX SuperPod, qui combine huit NVL72 pour un total de 288 CPU, 576 GPU, et 240 TB de mémoire. De quoi atteindre… 11,5 exaflops par unité selon l’entreprise. Pour référence, le supercalculateur le plus puissant du monde, Frontier, dépasse à peine la barre de l’exaflops…

Certes, les deux systèmes ne sont pas tout à fait comparables puisqu’ils reposent sur des architectures très différentes. Mais ces chiffres ahurissants illustrent tout de même le fait qu’Nvidia est en train de frapper un très, très grand coup avec Blackwell. L’avenir s’annonce radieux pour l’écurie de Jensen Huang, qui semble parfaitement positionnée pour consolider sa place de leader incontesté et incontestable du hardware IA.

On peut affirmer sans trop de risque que Microsoft, Google, Amazon, Meta, OpenAI et les autres acteurs de cette « révolution de l’IA » salivent déjà à l’idée de mettre la main sur ces nouveaux composants qui promettent de faire passer cette technologie dans une nouvelle ère.

🟣 Pour ne manquer aucune news sur le Journal du Geek, abonnez-vous sur Google Actualités. Et si vous nous adorez, on a une newsletter tous les matins.

Y a pas un moment où ils vont se dire qu à côté, c’est moins rentables les GPUs pour gamers et où ils vont arrêter cette partie de leur activitée?

A moins qu’il soit possible de faire du rendu vidéo avec les même puces, voir avec les rebus de fabrication de la branche AI.